14,4 seconden om een TikTok te controleren op nepnieuws en zelfmoord

TikTok zegt er alles aan te doen om een 'veilige plek' te zijn voor de veelal jonge gebruikers. Toch past het bedrijf zijn eigen regels niet erg streng toe, ontdekte RTL Nieuws-journalist Timo Nijssen, die een maand lang undercover ging bij het bedrijf.

Onzeker kijkt het meisje in de camera van haar telefoon. Terwijl de muziek speelt doet ze haastig een dansje, waarbij ze vooral haar handen en armen beweegt en schichtig om zich heen kijkt. Ze lijkt 8, hooguit 9 jaar oud. Dan, alsof ze bijna betrapt wordt door een ouder, pakt ze de telefoon en stopt het filmpje.

'Suspected underage user' (vermoedelijk minderjarige gebruiker) klik ik aan. Je moet namelijk minstens 13 jaar oud zijn om op TikTok te zitten. Het meisje raakt nu waarschijnlijk haar account kwijt, maar veel tijd om daarover na te denken heb ik niet. Het volgende filmpje staat alweer klaar.

Tienduizend moderatoren

Dit is wat ik als moderator doe: aan de lopende band filmpjes bekijken en beoordelen of gebruikers de regels van TikTok overtreden. Wereldwijd doen meer dan tienduizend moderatoren dit werk voor TikTok. Dat gebeurt vanuit tientallen locaties. Van Amsterdam (waar ik werk) tot Sydney en van Dublin tot Singapore.

Het van oorsprong Chinese TikTok werd in 2017 gelanceerd en is in korte tijd uitgegroeid tot een van de grootste socialmediaplatforms. Vorig jaar waren er een miljard gebruikers. Volgens onderzoeksbureau Newcom zitten er 3 miljoen Nederlanders op de app voor korte filmpjes. Veel van hen zijn erg jong. Van de Nederlandse kinderen tussen de 9 en 13 jaar zegt 86 procent op TikTok te zitten, bleek uit een onderzoek van het Jeugdjournaal. En dat terwijl de minimumleeftijd van het platform 13 jaar is.

Platform schoonhouden

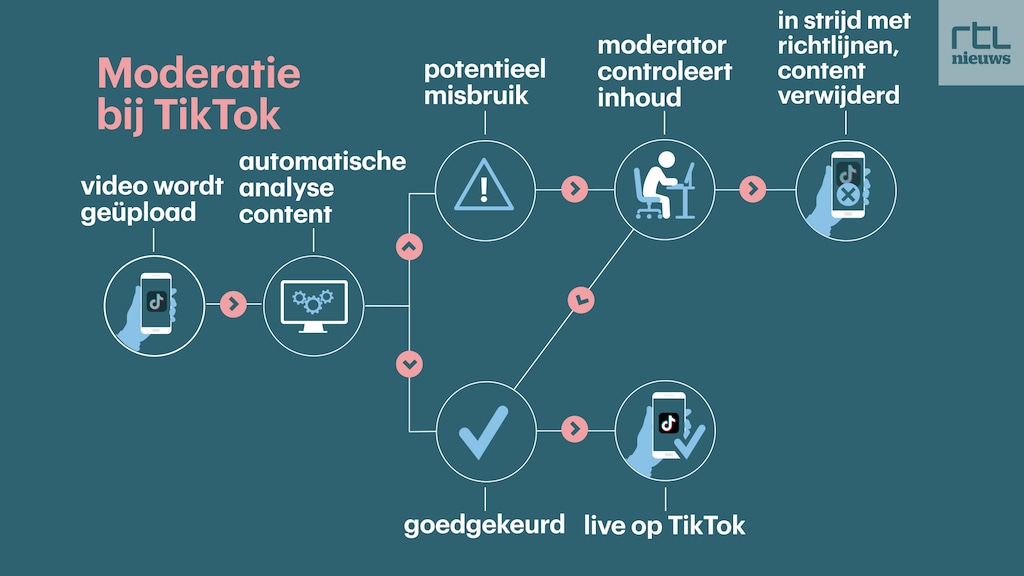

Alle grote sociale media – van Instagram en Facebook tot YouTube en Twitter – modereren om hun platforms schoon te houden. Deels gebeurt dat automatisch door software, deels wordt het werk door mensen gedaan.

Ex-moderatoren klagen socialmediabedrijven aan omdat het werk traumatiserend zou zijn

Dat gaat niet altijd goed. Zo lukte het TikTok twee jaar terug niet om een zelfmoordvideo offline te halen doordat gebruikers het steeds in een net iets andere vorm opnieuw uploadden. Meerdere ex-moderatoren van Facebook en YouTube hebben aan media verteld hoe ze naar de meest gruwelijke beelden moesten kijken en daardoor getraumatiseerd raakten. Dat leidde tot rechtszaken, die voor miljoenen dollars werden geschikt. Ook TikTok is inmiddels door voormalige medewerkers aangeklaagd omdat het werk traumatiserend zou zijn.

TikTok wil de vrolijkste plek op internet zijn. 70 procent van de TikToks wordt bekeken via de Voor Jou-pagina, waar een algoritme gebruikers filmpjes voorschotelt die nauw aansluiten bij hun interesses. Anders dan op bijvoorbeeld Instagram krijg je volop beelden te zien van accounts waarvan je nooit eerder hebt gehoord en kun je als gebruiker het algoritme nauwelijks bijsturen. Zaak dus om die beeldenstroom veilig te houden.

Vacature

Al deze zaken maken mij benieuwd hoe het modereren bij TikTok er achter de schermen uitziet. Toevallig krijg ik eind december op LinkedIn een berichtje van een recruiter van TikTok met een vacature. Ik besluit een reactie met mijn cv te sturen, en al snel belt ze me om een sollicitatiegesprek via Zoom in te plannen.

Tijdens dat gesprek wordt gevraagd of ik tegen heftige beelden en repetitief werk kan. Ik zeg van wel en voor ik het weet word ik aangenomen. Een koerier bezorgt een werklaptop en begin maart mag ik aan de slag.

Het bedrijf is op dat moment druk bezig met het opzetten van de moderatiehub in Amsterdam. Een fysiek kantoor is er nog niet, dus alles wordt vanuit huis gedaan. Ik doorloop Zoomend de trainingsweken, waarin mijn 22 nieuwe collega's en ik wegwijs worden gemaakt in de moderatieregels van TikTok.

Veel regels

Trainers geven ons uitleg bij de in totaal 153 moderatieregels, die beschreven staan in een dik handboek van 177 pagina's. Twee weken lang krijgen we presentaties waarin slides met voorbeeldvideo's worden getoond. Ik word er nogal gaar van, maar omdat we onze webcams aan moeten houden, moet ik bij de les blijven.

Daarna gaan we oefenmodereren. We brengen de regels in de praktijk door video's te beoordelen die al eerder door een ervaren medewerker zijn bekeken.

Bloederige video's

In sommige gevallen zijn die regels zeer gedetailleerd. Bijvoorbeeld bij bloederige video's die niet op TikTok mogen. Bepalen of iets te bloederig is, gebeurt met bijna wetenschappelijke precisie. Een ledemaat moet voor een derde met bloed bedekt zijn om als bloederig te tellen. Maar als het duidelijk een fictieve setting is, dan moet minstens een derde van het hele beeld bebloed zijn.

"De regel voor nepnieuws gebruik je nooit bij het modereren"

Op andere gebieden zijn de richtlijnen minder precies. Bijvoorbeeld als het op de verspreiding van valse informatie aankomt. Zo is iets volgens TikTok alleen nepnieuws als er een 'nieuwssetting' wordt nagebootst. Een vlog waarin desinformatie wordt verkondigd, is geen nepnieuws. Dezelfde inhoud vanuit een televisiestudio wel. Het zorgt ervoor dat de richtlijn in de praktijk niet werkt. "Ik werk hier nu 2,5 jaar en heb die regel nog nooit gebruikt", zegt de trainer.

Dat verbaast socialmedia-expert Marieke Kuypers niet. Zij onderzoekt desinformatie die rondgaat op TikTok en maakt er op haar eigen account factchecks over. "Het overgrote deel van de schadelijke nepverhalen wordt verteld door gewone TikTokkers. Dat zijn geen mensen die in een nieuwsstudio zitten."

Niet zelf googelen

Tijdens het oefenmodereren kom ik een video tegen waarin links worden gelegd tussen het Oekraïense leger en neonazi's. Ik wil de beweringen googelen, maar van mijn trainer krijg ik te horen dat dat niet de bedoeling is. In het handboek staat alleen een aantal hele bekende vormen van desinformatie, de rest moet je maar laten gaan. Complottheorieën, bijvoorbeeld dat de coronapandemie een vooropgezet plan zou zijn van een wereldelite, worden sowieso niet verwijderd en alleen minder zichtbaar gemaakt. Dat gaat in tegen wat TikTok publiekelijk beweert. In de communityrichtlijnen die iedere gebruiker in de app kan nalezen, staat namelijk dat alle schadelijke desinformatie verwijderd wordt.

Het is niet de bedoeling dat moderatoren zelf video's gaan factchecken

"TikTok durft geen beslissingen te nemen over inhoud", zegt Kuypers. "Dat is ook moeilijk, je hebt specialisten nodig die weten wat er rondgaat en wat daar wel en niet van klopt." Volgens Kuypers ontbreekt die kennis nog bij het bedrijf, zeker als het gaat over desinformatie die specifiek in Nederland rondgaat.

TikTok ondertekende deze maand samen met andere grote techbedrijven een nieuwe Europese regels om desinformatie tegen te gaan. Daarin zeggen de bedrijven onder meer toe om samen te werken met onafhankelijke factcheckers, berichten van betrouwbare bronnen prominenter te tonen en valse berichten juist minder bereik te geven. Het niet naleven van de gedragscode kan leiden tot hoge boetes.

Regels veranderen doorlopend

Het kost me veel moeite om alle regels bij te houden. Een kort broekje bij een kind is al gauw te kort, terwijl bij volwassenen de allerkleinste string al als bedekking geldt – tenzij het een doorzichtige stof is. De regels veranderen bovendien doorlopend, waarvoor wekelijks bijpraatsessies worden gehouden. Zo mogen we de tag voor 'seksueel taalgebruik' eerst volop aanklikken, maar na een wijziging mag die tag alleen nog voor uitzonderlijk expliciete teksten gebruikt worden. Kinderen in een badjas gelden eerst als 'minderjarige in minimale kleding', later blijkt het toch prima te zijn.

De regels werken bovendien beperkend. Tijdens het oefenen krijgt mijn team een filmpje voorgeschoteld waarin een jonge kerel met een jachtmes over straat loopt. TikTok heeft uitgebreide regels die het verbieden om illegale vuurwapens te laten zien, maar over steekwapens wordt met geen woord gerept. Dus klikken we maar aan dat het 'onjuist gebruik van gevaarlijke spullen' is.

Het blijkt een strikvraag. Met een jachtmes over straat lopen is geen 'onjuist gebruik', zegt de trainer, dus moeten we de video laten gaan. Was het een broodmes geweest dat in de keuken thuishoort, dan hadden we wel goed gehandeld.

TikTok zegt de regels aan lokale wetten en gebruiken aan te passen. Daardoor mogen bikini's wel in Europa, maar niet in Saoedi-Arabië. Toch geldt dat niet voor alle regels: wiet mag bijvoorbeeld nooit, ook niet in landen waar het legaal is.

Aan de slag

Ondanks de vele verschillende onderwerpen die tijdens de trainingen aan bod komen, blijkt het werk in de praktijk erg monotoon. Het moderatiesysteem schotelt me een pagina voor met daarop tien video's. Die kan ik versneld of juist vertraagd afspelen.

Naast de video worden screenshots uit het filmpje getoond, soms met gele markeringen op plekken waar het systeem zelf denkt iets te zien – bijvoorbeeld een blote onderbuik. Rechts van het filmpje staat een veld waar ik de juiste moderatieregel moet aanklikken. Taggen heet dat. Het systeem doet wat suggesties, maar ik kan ook zelf zoeken naar de juiste tag.

Na het beoordelen van de video's klik ik op submit en krijg ik direct weer tien nieuwe video's. En weer tien video's. Zo gaat het urenlang door tot de pauze. Het gaat me duizelen, eindeloos hoor ik dezelfde liedjes die ik vervolgens niet meer uit mijn hoofd krijg.

Wellnesstips

Via het interne chatprogramma krijgen we zo nu en dan een wellnesstip toegestuurd. Een YouTube-filmpje met rek- en strekoefeningen bijvoorbeeld, om de kramp van de hele dag kromgebogen achter een laptop zitten te verminderen.

Van tevoren dacht ik actief video's te moeten verwijderen, maar zo blijkt het systeem niet in elkaar te zitten. Ik kies één of meerdere regels die in het filmpje worden overtreden en de computer voert dan automatisch de bijbehorende actie uit. Is iets seks, dan wordt de video direct verwijderd. Maar wordt er in het filmpje een sigaret gerookt, dan klik ik 'tabakspromotie' aan en wordt de video alleen wat minder prominent getoond in de app.

Werk door de computer laten doen

Ons uitgebreide geklik in het moderatiesysteem wordt ook gebruikt om onszelf overbodig te maken, krijgt mijn team te horen. TikTok gebruikt de beoordelingen die menselijke moderatoren geven om de automatische software steeds slimmer te maken. Zo wil TikTok steeds meer werk door de computer laten doen.

Een computer kan video's immers sneller beoordelen dan mensen. En tempo, daar draait het uiteindelijk om. Het moderatiesysteem houdt nauwgezet mijn productiviteit bij. Hoe lang doe ik over het beoordelen van een video? Hoeveel video's bekijk ik per uur? Hoeveel fouten maak ik?

Moderatoren krijgen 14,4 seconden om een video te bekijken, beoordelen en taggen

Rechtsboven in het moderatiescherm laat een teller zien hoeveel video's ik per uur beoordeel, met daarachter wat het beoogde target is. Op het hoogtepunt kom ik in de buurt van 180 video's per uur, terwijl het target op 250 ligt – 14,4 seconden om een video te bekijken, beoordelen en taggen. Moderatoren die er al wat langer werken, zeggen de video's vaak niet eens te bekijken en puur te taggen op basis van de screenshots.

Trends

Al na een paar uur achter het moderatiescherm begin ik trends te herkennen in de filmpjes die ik voorgeschoteld krijg. Ik zie veel filmpjes van Britse scholieren die een liedje afspelen met de tekst 'my name, my age, my favorite color', waarbij ze in beeld hun antwoord laten zien. Het maakt mijn werk erg makkelijk: zodra ik bij my age '10' zie staan, klik ik 'vermoedelijk te jonge gebruiker' aan en ga ik door naar de volgende video.

De hoeveelheid jonge kinderen die ik voorbij zie komen, valt me op. Bij ongeveer de helft van de filmpjes die ik zie, vermoed ik dat de gebruiker jonger is dan 13 jaar. Soms zelfs zo jong dat ze nog niet kunnen typen en wat willekeurige letters als bijschrift bij hun video plaatsen.

Een minder vrolijke trend vormen de video's waarin gebruikers vertellen dat ze zichzelf willen verwonden of een einde aan hun leven willen maken. Iedere dag zie ik ze voorbijkomen. Ze komen op mij over als een schreeuw om hulp, maar die kan ik de gebruikers niet bieden. Het systeem biedt geen enkele manier om een gebruiker een berichtje te sturen.

Emergency response team

Ik kan het alleen maar markeren als 'neiging tot zelfverwonding of suïcide'. Volgens het handboek wordt de video dan verwijderd en kan het speciale emergency response team (ERT) ernaar kijken. Dat team kan gebruikers doorverwijzen naar hulpdiensten zoals 113. Als moderator hoor je niet wat er uiteindelijk met de gebruiker is gebeurd.

Als moderator krijg ik niet te horen wat er met mijn meldingen over suïcidale gebruikers gebeurt

Bij 113 is er over dat soort verwijzingen niets bekend. "Ik heb nog nooit gehoord dat er mensen benaderd worden en naar ons verwezen", zegt Scarlet Hemkes van de zelfmoordpreventielijn. "Het lijkt me ook niet prettig dat je als moderator niet weet wat er met je melding gebeurt."

Na publicatie laat TikTok aan RTL Nieuws weten dat gebruikers in geval van nood alleen bij de politie gemeld worden. 113 op de hoogte stellen zou TikTok niet mogen doen wegens de privacy van de gebruiker.

Intentie

TikToks openbare communityrichtlijnen zijn duidelijk over dit soort video's: die mogen niet geplaatst worden. Maar in het interne moderatiehandboek staat dat er voor verwijdering wel een 'intentie' van de gebruiker moet zijn om zichzelf iets aan te doen. Context, zoals andere video's die de gebruiker heeft geplaatst, krijg ik niet te zien. Hoe serieus is de intentie van een gebruiker die playbackt op een suïcidale songtekst? En hoe kan ik dat in minder dan 15 seconden bepalen?

"Dat lijkt me geheel niet haalbaar", zegt Hemkes van 113 als ik het aan haar voorleg. "Iemands intentie is heel lastig vast te stellen, zeker voor iemand die daar niet veel ervaring mee heeft. Een cursus van een halve dag met wat voorbeeldvideo's is niet genoeg om je daarin te trainen."

Ik neem liever het zekere voor het onzekere en klik de tag voor suïcidale neigingen volop aan. Maar ook dat is niet de bedoeling, hoor ik van een instructeur. Enige terughoudendheid is gewenst, anders krijgt het ERT te veel video's te verwerken.

Video wel, slideshow niet

Het ERT kijkt bovendien alleen mee in 'noodgevallen'. Een video waarin iemand zijn polsen doorsnijdt telt als een noodgeval, maar een fotoslideshow waarin hetzelfde te zien is niet. TikTok vindt dat er dan geen sprake is van een levensbedreigende situatie.

De richtlijnen blijken in de praktijk niet goed aan te sluiten bij wat ik te zien krijg. Zo zijn de regels rond zelfbeschadiging vooral gericht op zichtbare verwondingen, zoals bloederige snijwonden. Misschien dat die er door de software al uitgefilterd worden, maar ik krijg ze niet in mijn moderatiescherm voorgeschoteld.

Gebruikers spellen woorden expres verkeerd om door de moderatie heen te komen

De video's over zelfverwonding die ik wel zie, zijn veel minder direct. Gebruikers spellen woorden expres verkeerd of gebruiken synoniemen: 'mezelf onlevend maken' in plaats van 'mezelf doden'. Ook valt me op dat veel gebruikers niet rechtstreeks iets zeggen over zelfverminking, maar gebruikmaken van TikToks muziekfunctie. Daarmee lipsyncen ze op een nummer met een songtekst over het onderwerp. En daar zijn de regels weer veel minder duidelijk en streng over. Veel van dit soort video's glippen op die manier door de moderatiemachine.

Seksuele muziek

De muziekfunctie is een van de dingen die TikTok zo populair maakt. De app heeft een uitgebreide catalogus aan geluiden die je onder je filmpje kunt plakken. Soms zijn dat soundbites waaraan grappen worden opgehangen, vaker zijn het korte muziekclips.

Tijdens het modereren hoor ik behoorlijk wat seksueel expliciete muziek over orale seks en prostitutie. Ook gebruikers onder de 18 playbacken op die nummers. Volgens de openbare regels van TikTok is alles wat met minderjarigen en seks te maken heeft, streng verboden. Maar in het interne handboek staat ook hierbij dat de uploader een 'duidelijke intentie' moet hebben om de kijker seksueel op te winden. Anders moeten we het goedkeuren.

En ook hierbij is het moeilijk om die intentie te bepalen. Iemand die playbackt op een liedje over seks en daarbij bewegingen nadoet: is dat grappig bedoeld of is het een 'duidelijke intentie'? Video's waarin dat gebeurt, zijn in elk geval volop te vinden op TikTok.

Productiviteitsscores

Tijdens mijn proeftijd heb ik een paar keer een gesprek met mijn manager. Daarin tovert ze spreadsheets tevoorschijn waarin mijn scores bijgehouden worden. Ik scoor goed op kwaliteit, zegt ze, wat inhoudt dat ik vaak de juiste moderatieregel kies. Maar ik ben veel te traag. Sterker nog, ik ga na een paar dagen volgens het systeem zelfs langzamer werken.

Ik ben wat trager gaan werken omdat ik een paar ingewikkelde gevallen te zien kreeg, zeg ik tegen mijn manager. Daardoor had ik meer tijd nodig om het handboek erop na te slaan. Mijn manager knikt begripvol, maar wil dat ik toch flink sneller ga werken. Ze regelt dat ik met een meer ervaren medewerker mee kan kijken.

Die collega laat me zien hoe hij in het wilde weg klikt in het systeem om maar te voorkomen dat zijn status op 'inactief' springt. Dat gebeurt vanzelf als je 15 minuten of langer niet aan het modereren bent. Iets om te vermijden, want meer dan drie keer per week op inactief staan is een reden om je proeftijd niet te verlengen.

Sprintje trekken

Soms lukt het me om een sprintje te trekken en mijn gemiddeldes wat op te krikken. Dan krijg ik een aantal simpele video's voorgeschoteld die ik zonder nadenken kan beoordelen. Maar over het algemeen vind ik het ondoenlijk om in een paar seconden een video te beoordelen en daarbij ook nog rekening te houden met alle nuances uit het dikke handboek.

Tegen het eind van de eerste maand gaan we live: we gaan het echte moderatiewerk doen. Waar we tijdens de trainingsperiode nog van maandag tot vrijdag werkten, volgen we nu een rooster met ploegendiensten van maandag tot zondag. In eerste instantie van 9.00 tot 18.00 uur, maar in de toekomst ook 's avonds en 's nachts, zo wordt ons verteld. Wekelijks werk je vijf dagen, maar de twee vrije dagen zijn niet per se aaneengesloten. Wie op een feestdag per se vrij wil hebben, moet daarvoor een van zijn 25 vakantiedagen opnemen – of geluk hebben en niet ingeroosterd worden.

De laatste dag van de proefmaand neem ik ontslag. Ik bel mijn manager. Ze vindt het jammer dat ik wegga, maar handelt het vervolgens zo efficiënt mogelijk af. In een gesprek van nog geen vijf minuten zegt ze welke stappen ik moet doorlopen in het hr-systeem. Alles om de machine van TikTok soepel te laten lopen. Twee uur later is mijn account geblokkeerd en kan ik mijn collega's niet meer spreken. De IT-afdeling stuurt me een e-mail: de koerier komt de laptop weer ophalen.

Reactie TikTok

TikTok laat in een reactie weten dat ze met duizenden mensen er aan werken om het netwerk veilig en leuk te houden. Het bedrijf blijft er bij dat content die zelfmoord verheerlijkt of promoot verwijderd wordt en dat de moderatoren hiervoor getraind worden. Verder geeft het bedrijf aan dat het fact-checkers, 'veiligheids-professionals' en moderatoren inzet om het netwerk vrij van desinformatie te houden.

Tegelijk zegt TikTok continu te streven naar verbetering van de content moderatie. Dat betekent ook dat ze kijken naar beslissingen van moderatoren, om te 'begrijpen waar sommige content niet in een eerdere fase is tegengehouden'. Lees de volledige reactie hier.

Verantwoording

Journalist Timo Nijssen werkte van 7 maart tot en met 6 april 2022 undercover bij het contentmoderatieteam van TikTok in Amsterdam. Tijdens die maand volgde hij trainingen over de moderatieregels van het bedrijf. Daarna deed hij nog twee dagen het echte werk. Om de undercoverperiode niet onnodig lang te laten duren, nam hij daarna ontslag.

Nijssen werd zelf benaderd door een recruiter van het bedrijf en solliciteerde onder zijn eigen naam. RTL Nieuws heeft TikTok achteraf ingelicht en het bedrijf de mogelijkheid gegeven om te reageren. Gezien de enorme populariteit en invloed van TikTok acht RTL Nieuws de undercovermethode geoorloofd. Alleen op die manier is het mogelijk om achter de schermen te kijken bij een machtig techbedrijf.

Denk je aan zelfdoding?

Bel dan 24/7 met 113, gratis en anoniem, of chat op 113.nl

Dit artikel is om 14:14 uur aangevuld met een extra reactie van TikTok over verwijzingen naar 113.